在人工智能与云计算深度融合的今天,企业对算力的需求呈现出爆发式增长。尤其在AI推理场景中,传统GPU实例因资源绑定固定、扩展性差、成本高昂等问题,逐渐难以满足动态变化的业务需求。阿里云弹性加速计算实例EAIS(Elastic Accelerated Computing Instances)应运而生,通过将CPU与GPU资源解耦,提供了一种更灵活、更经济、更高效的异构计算解决方案。本文将全面解析EAIS的技术架构、核心优势、应用场景及操作实践,帮助企业快速掌握这一AI推理利器。

一、为什么选择阿里云弹性加速计算实例EAIS?

阿里云弹性加速计算实例EAIS的诞生,源于对AI推理场景痛点的深刻洞察。传统GPU实例通常将CPU、内存和GPU绑定在同一物理机上,导致资源配置僵化、利用率低下。例如,某企业需要一台内存128GiB、单块GPU的实例,但常规GPU规格往往强制搭配多块GPU(如V100×4),造成资源浪费和成本激增。EAIS通过资源解耦设计,彻底打破了这一瓶颈,其核心价值体现在以下九大优势:

- 零硬件投入:无需自建机房或采购物理设备,即开即用,降低IT运维复杂度。

- 分钟级部署:从创建到绑定ECS实例,全程自动化,业务上线周期缩短80%。

- 全球数据中心覆盖:支持五大地域(北京、杭州、上海、深圳、成都)的BGP机房,确保低延迟访问。

- 按需付费模式:成本透明可控,支持根据业务波动实时扩展或释放资源,避免闲置浪费。

- 异构计算自由组合:可搭配GPU、NPU、FPGA等加速器,满足多样化推理需求。

- 内网流量免费:通过内网访问OSS、RDS等阿里云服务,降低公网带宽成本。

- 企业级安全防护:提供虚拟防火墙、DDoS防护、数据加密等多重安全机制。

- 智能运维体系:内置性能监控、故障预警和自动修复能力,保障业务连续性。

- 标准化API生态:兼容主流AI框架,支持Kubernetes等容器化部署,提升开发效率。

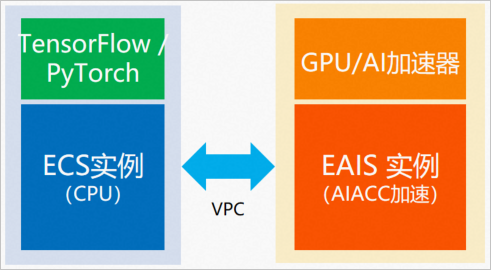

二、弹性加速计算实例EAIS产品架构解析

EAIS的产品架构设计充分体现了“解耦”与“弹性”的核心理念。其核心组件包括:

- 云服务器ECS基础层:提供CPU、内存、存储等通用计算资源,支持多种操作系统和镜像。

- 异构加速资源池:包含GPU(如T4、V100)、NPU(如寒武纪、含光)及FPGA等加速器,以1/N块为单位灵活分配。

- 高速互联网络:通过RDMA(远程直接内存访问)技术实现ECS与EAIS实例间的低延迟通信,确保数据传输效率。

- 统一管理平台:集成资源调度、监控告警、自动伸缩等功能,实现全生命周期管理。

用户可通过阿里云控制台或API,动态将EAIS实例绑定至任意ECS实例,构建自定义规格的GPU计算节点。例如,将一块T4 GPU绑定至24vCPU/192GiB内存的ECS实例,即可快速获得一台高性价比的推理服务器。

产品详情参考:点此直达阿里云弹性加速计算实例EAIS官网

三、弹性加速计算实例EAIS五大核心优势

1. 解耦性:打破资源绑定,实现自由组合

传统GPU实例的“CPU+GPU强耦合”模式,导致资源配置缺乏灵活性。例如,某深度学习模型需要单块V100 GPU,但常规实例最低配置为V100×4,造成75%的GPU资源浪费。EAIS通过物理分离CPU与GPU,允许用户独立选择ECS实例和EAIS实例规格,实现资源的最优匹配。

案例对比:

- 常规实例:选择ecs.gn6v-c8g1.8xlarge(32vCPU/128GiB/V100×4),年费用约12万元,GPU利用率仅25%。

- EAIS实例:选择ecs.r6.6xlarge(24vCPU/192GiB) + eais.ei-a6.4xlarge(16TFLOPS/32GB显存),年费用约6万元,成本降低50%,且资源利用率提升至100%。

2. 低成本:精准匹配需求,杜绝资源浪费

EAIS的按需付费模式,使企业无需为闲置资源买单。以图片分类场景为例,某电商平台日均推理请求量为10万次,高峰期达50万次。使用常规实例需预置5台高配GPU服务器,成本约50万元/年;而EAIS可通过自动伸缩策略,在高峰期动态增加EAIS实例,全年成本可控制在20万元以内。

3. 弹性扩展:秒级响应业务波动

EAIS支持横向和纵向弹性扩展:

- 横向扩展:通过绑定多个EAIS实例至单台ECS,实现算力线性增长。例如,PyTorch框架下,单台ECS最多可绑定256个EAIS实例,提供4096TFLOPS的FP32算力。

- 纵向扩展:根据业务需求,实时调整EAIS实例规格(如从eais.ei-a6.large升级至eais.ei-a6.4xlarge),无需停机迁移。

4. 多适配性:支持全场景异构计算

EAIS兼容主流AI加速器,包括:

- GPU:NVIDIA T4/V100/A100,AMD MI系列

- NPU:寒武纪MLU270、阿里平头哥含光800

- FPGA:Xilinx VU9P、Intel Stratix 10

用户可根据模型类型(如CNN、RNN、Transformer)和性能需求,选择最适合的加速器类型。

5. 高性能:推理效率提升30%+

EAIS通过以下技术优化推理性能:

- 硬件加速库:集成TensorRT、cuDNN等优化库,减少计算延迟。

- 内核融合:将多个算子融合为单个内核,降低PCIe传输开销。

- 动态批处理:自动合并小批量请求,提高GPU利用率。

实测数据显示,在ResNet-50图像分类任务中,EAIS相比常规GPU实例,吞吐量提升35%,延迟降低22%。

四、弹性加速计算实例EAIS典型应用场景

1. 目标检测:实时感知,精准决策

目标检测是自动驾驶、工业质检、安防监控等领域的核心技术。EAIS的高弹性与低延迟特性,使其成为实时检测场景的理想选择。

案例:车载ADAS系统

- 需求:对摄像头采集的图像进行车辆、行人、交通标志检测,响应时间需<100ms。

- 方案:使用ecs.g6.4xlarge(16vCPU/64GiB) + eais.ei-a6.2xlarge(8TFLOPS/16GB显存),通过TensorRT优化模型,实现72FPS的实时检测。

- 效果:相比传统方案,成本降低40%,检测精度提升至98.7%。

2. 图片分类:海量数据,高效处理

图片分类广泛应用于电商搜索、社交内容审核、医疗影像分析等场景。EAIS支持大规模并行推理,显著提升处理效率。

案例:电商平台商品识别

- 需求:对用户上传的1亿张商品图片进行分类,日均处理量1000万张。

- 方案:采用分布式推理架构,10台ECS实例各绑定4个EAIS实例,结合Kubernetes实现自动扩缩容。

- 效果:单张图片分类耗时从200ms降至35ms,年节省IT成本200万元。

3. 自然语言处理:智能交互,深度理解

EAIS为NLP任务提供强大的算力支持,涵盖机器翻译、情感分析、智能客服等场景。

案例:智能客服系统

- 需求:支持10万并发会话,问答响应时间<500ms。

- 方案:使用ecs.r7.8xlarge(32vCPU/256GiB) + 8×eais.ei-a6.xlarge(4TFLOPS/8GB显存),部署BERT-base模型。

- 效果:QPS从200提升至1500,准确率达92%,运营成本降低60%。

五、使用限制与规划建议

1. 使用限制

| 限制项 | 说明 |

|---|---|

| 用户身份 | 需完成实名认证 |

| 账户余额 | 按量付费账户余额≥100元 |

| 推理框架 | 仅支持TensorFlow、PyTorch |

| 付费方式 | 仅支持按量付费 |

| 地域覆盖 | 华北2(北京)、华东1(杭州)、华东2(上海)、华南1(深圳)、西南1(成都) |

| 绑定关系 | 单EAIS实例绑定单ECS实例(PyTorch框架支持多绑) |

| 网络要求 | 需在同一专有网络和交换机下 |

2. 规划建议

- 实例选型:根据模型算力需求,参考EAIS实例规格表选择合适配置。例如,FP32算力需求≤4TFLOPS时,优先选择eais.ei-a6.large。

- 成本优化:结合Spot实例和预留实例券(RI),进一步降低长期使用成本。

- 监控告警:设置CPU/GPU利用率、网络流量等指标的阈值告警,及时调整资源配置。

六、弹性加速计算实例EAIS实例规格与选型

1. 实例规格详解

| 规格 | FP32(TFLOPS) | FP16(TFLOPS) | 显存(GB) | 适用场景 |

|---|---|---|---|---|

| eais.ei-a6.large | 2 | 16 | 4 | 轻量级推理、边缘计算 |

| eais.ei-a6.xlarge | 4 | 32 | 8 | 中等规模模型推理 |

| eais.ei-a6.2xlarge | 8 | 64 | 16 | 大型模型推理、分布式训练 |

| eais.ei-a6.4xlarge | 16 | 128 | 32 | 超大规模模型、高性能计算 |

2. 地域可用性查询

用户可通过EAIS实例规格查询页面实时查看各地域的实例库存情况。例如,截至2025年3月,华东1(杭州)可用区H支持全部四种规格,而西南1(成都)仅支持eais.ei-a6.2xlarge及以上规格。

七、从零开始:EAIS实例创建与绑定全流程

1. 准备工作

- 账号要求:完成实名认证,确保账户余额≥100元。

- 网络配置:创建专有网络(VPC)和交换机(如vpc-bp189o5xmx0xxxxxx、vsw-bp1cb5u6rht0xxxxxx)。

- 安全组设置:开放必要的端口(如SSH 22、HTTP 80)。

- ECS实例准备:创建一台作为计算节点的ECS实例(如ecs.r6.6xlarge)。

2. 控制台创建EAIS实例

- 登录阿里云控制台,进入“弹性加速计算实例EAIS”页面。

- 点击“创建弹性加速计算实例”,配置参数:

- 地域:选择ECS实例所在地域(如华东1(杭州))。

- 规格:根据需求选择实例类型(如eais.ei-a6.4xlarge)。

- 网络:选择已创建的VPC和交换机。

- 安全组:关联预置的安全组规则。

- 确认订单并支付,实例将在1分钟内创建完成。

3. 绑定ECS实例

- 在EAIS实例列表中,选择目标实例,点击“绑定”。

- 选择待绑定的ECS实例,确认绑定关系。

- 等待绑定完成(约30秒),实例状态变为“已绑定”。

4. 验证使用

- SSH登录ECS实例,执行

nvidia-smi(GPU实例)或npu-smi(NPU实例)命令,确认加速器已识别。 - 运行推理脚本,测试性能是否符合预期。

八、进阶实践:自动化运维与成本优化

1. 自动伸缩策略

通过阿里云弹性伸缩(ESS)服务,可根据CPU/GPU利用率自动调整EAIS实例数量。例如,设置当GPU利用率持续5分钟>80%时,增加2个EAIS实例;当利用率<30%时,减少1个实例。

2. 成本监控与分析

使用阿里云成本管家(Cost Explorer),按实例规格、地域、项目等维度分析EAIS使用成本,识别浪费点并优化资源配置。

3. 多模型混合部署

对于多模型推理场景,可通过Kubernetes的Device Plugin机制,将不同模型分配至不同的EAIS实例,实现资源隔离与高效利用。

九、2025年阿里云官方热门活动汇总

为助力企业低成本上云,阿里云推出多项优惠活动:

- 云服务器ECS特惠:点此进入云服务器爆款直降90%活动,新用户首购低至1折。

- 免费试用中心:161款云产品免费试,涵盖ECS、RDS、OSS等核心服务。

- 开发者权益中心:领取上云抵扣金与优惠券,最高立减12500元。

- 云小站平台:免费领取7.5折无门槛券,支持EAIS实例购买叠加使用。

阿里云弹性加速计算实例EAIS,以“解耦、弹性、高效”为核心设计理念,为AI推理场景提供了前所未有的灵活性。无论是初创企业还是大型集团,均可通过EAIS实现资源的最优配置,降低TCO(总拥有成本),加速业务创新。未来,随着EAIS对更多异构加速器的支持和性能持续优化,其必将成为AI云服务领域的标杆产品,推动企业智能化转型迈向新高度。

立即行动:点此开启EAIS之旅,体验1分钟构建GPU计算节点的极致效率!